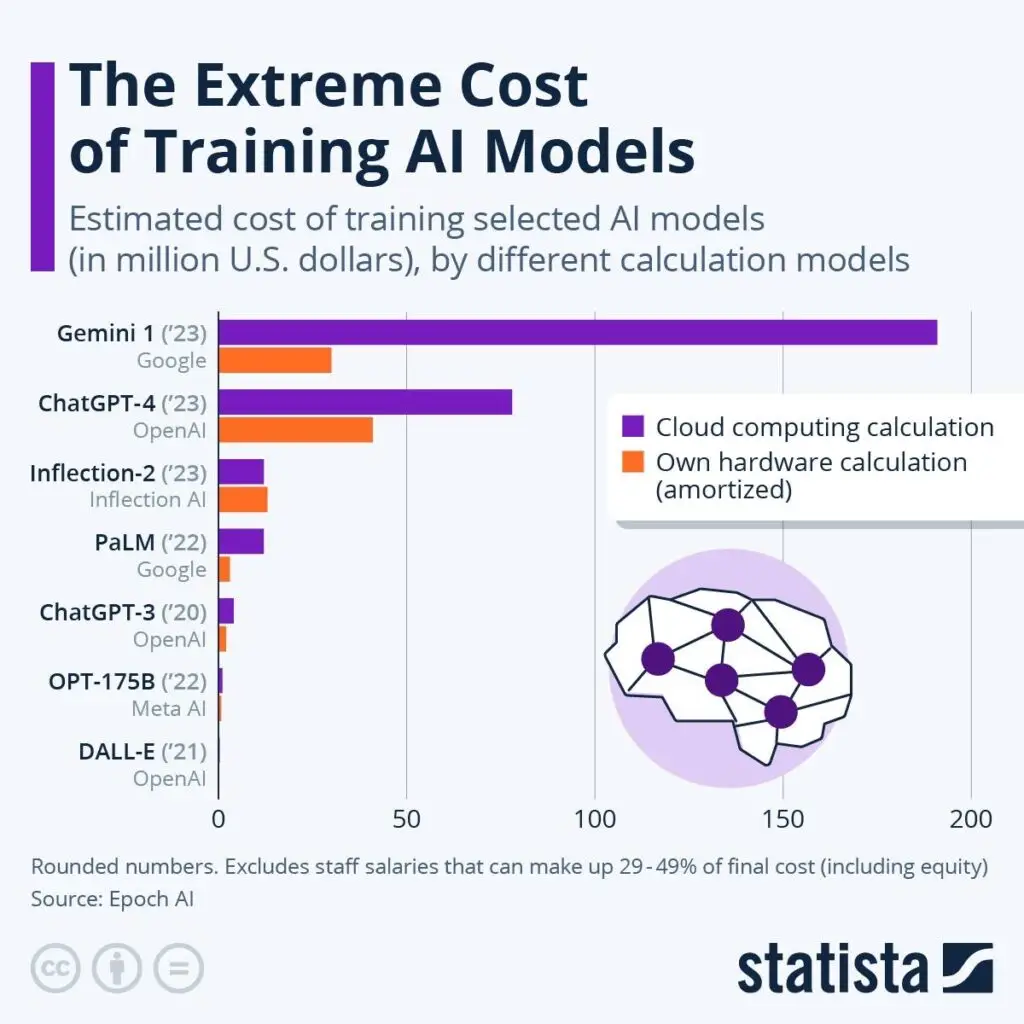

Forse la necessità è davvero la madre dell’ingegno. Da qualche giorno il mondo della tecnologia è in subbuglio perché una startup cinese, DeepSeek ha anche dimostrato prestazioni superiori in molti benchmark chiave a ChatGPT, la ben più blasonata e costosa intelligenza artificiale di OpenAI. Il tutto con una spesa minima: circa sei milioni di dollari per l’addestramento di un modello che batte quelli che richiedono agli americani molto di più per essere addestrati e fatti funzionare. Google nel 2023 per addestrare Gemini 1 ha speso più di 175 milioni di dollari, mentre OpenAI lo stesso anno, per addestrare ChatGPT-4, ha speso circa 75 milioni, secondo le stime di Epoch AI.

L’effetto è stato devastante per Wall Street, con Nvidia che ha perso il 13% in poche ore e altre big tech che hanno seguito a ruota. Ma mentre tutti si concentrano sul successo commerciale, nessuno sembra voler guardare il grande elefante nella stanza: qualche numero forse non torna.

La storia ufficiale vuole che DeepSeek abbia addestrato il suo modello con appena 2.048 GPU Nvidia H800, in circa in due mesi. Considerando un costo operativo di circa 2 dollari all’ora per GPU e facendo i vari calcoli saltano fuori circa 6 milioni di dollari per il solo addestramento. È come dire che qualcuno ha costruito una Ferrari nel garage di casa con un cacciavite e una scatola di pezzi comprati al Brico al prezzo di una Panda. OpenAI usa decine di migliaia di GPU molto più potenti (le H100) e ha bruciato miliardi di dollari per creare ChatGPT, senza contare l’impatto ambientale che tutt’ora i mega-server dell’azienda hanno quando elaborano i prompt degli utenti. Come è possibile questa magia tutta cinese?

L’efficienza non basta

La spiegazione ufficiale parla di un approccio innovativo all’efficienza. DeepSeek avrebbe sviluppato l’algoritmo DualPipe che ottimizza l’uso delle GPU in modo rivoluzionario. L’azienda sostiene anche che la natura open source del progetto (disponibile qui) abbia permesso di risparmiare enormemente sui costi di sviluppo grazie alle collaborazioni con le comunità di sviluppatori e ricercatori di tutto il mondo. Ma non tutti gli esperti sono convinti di quel che dice DeepSeek: anche con le migliori ottimizzazioni possibili, i numeri potrebbero non quadrare.

Il sospetto è che ci sia molto di più dietro alle dichiarazioni di DeepSeek, anche se potrebbe trattarsi invece di “disinformazione occidentale” per mettere zizzania e contenere quantomeno i danni in Borsa. Un doppio o triplo gioco per confondere le acque. Comunque, in America c’è chi dice (come Elon Musk o il ceo di Scale AI, Alexandr Wang) che DeepSeek potrebbe aver accumulato una scorta significativa di GPU H100 prima delle sanzioni americane, o essersele fatte recapitare passando da Singapore per aggirare i blocchi commerciali. Altri però parlano anche di possibili tecnologie “segrete” sviluppate in Cina di cui nessuno in Occidente conosce l’esistenza (pratica comune a molte startup, peraltro). E infine c’è anche chi guarda al ruolo del governo cinese, che potrebbe aver messo a disposizione le sue risorse di calcolo, cioè altre GPU comprate nel tempo da Pechino.

I numeri dietro al mistero

Ma quanto vanno davvero forte questi nuovi modelli di DeepSeek? In breve: tantissimo. DeepSeek ha rilasciato una famiglia completa di modelli, dal più piccolo che richiede appena 1,5 miliardi di parametri fino al mastodontico R1 con i suoi 671 miliardi di parametri totali. La vera innovazione sta nell’architettura Mixture of Experts (MoE) che permette di attivare solo 37 miliardi di parametri per ogni token processato, rendendo il modello molto più efficiente dei concorrenti. Mentre ChatGPT-4 deve elaborare tutti i suoi parametri per ogni risposta, DeepSeek può “accendere” solo le parti necessarie del modello.

La velocità di elaborazione è un altro punto di forza: DeepSeek-R1 genera 87,5 token al secondo e supporta una finestra di contesto di 128K token, numeri che sulla carta superano anche GPT-4. Il costo per milione di token è un terzo rispetto a OpenAI: 0,55 dollari contro 2,50 per l’input e 2,19 dollari contro 10 per l’output. Cifre che sembrano quasi troppo belle per essere vere, dicono gli esperti, soprattutto considerando i limiti hardware dichiarati.

Il paradosso delle sanzioni

La vicenda DeepSeek sta anche sollevando dubbi sull’efficacia reale delle sanzioni americane sui chip. Se un’azienda cinese può sviluppare un’AI di livello mondiale con hardware teoricamente limitato, significa che le restrizioni non stanno funzionando come previsto. O forse, come suggeriscono alcuni, stanno solo spingendo la Cina a sviluppare soluzioni alternative più efficienti.

L’impatto sul mercato borsistico è stato immediato e brutale. Gli investitori stanno riconsiderando le valutazioni stratosferiche delle aziende AI americane, basate sull’assunto che servano enormi risorse per competere in questo settore. Se DeepSeek ha davvero trovato una scorciatoia, l’intero castello potrebbe crollare. Il Progetto Stargate, appena annunciato da Donald Trump e voluto da Sam Altman e dal numero uno di SoftBank, Masayoshi Son, potrebbe essere nato morto.

E adesso cosa succederà?

Gli ultimi sviluppi non aiutano a chiarire il mistero. DeepSeek ha dichiarato di aver subito “attacchi informatici su larga scala” che l’hanno costretta a limitare le nuove registrazioni. Una mossa che alcuni vedono come un tentativo di guadagnare tempo mentre cresce l’attenzione internazionale sulla loro tecnologia. Intanto, negli Usa l’app di DeepSeek nell’App Store iOS di Apple è al primo posto tra le app gratuite, e la stessa cosa anche in Italia, davanti a quella di ChatGPT e al FantaSanremo.

Nel frattempo, le aziende americane si stanno muovendo più veloci che possono. OpenAI e Google hanno accelerato i loro progetti di ricerca, mentre il Dipartimento del Commercio dell’amministrazione Trump sta esaminando attentamente il caso per possibili violazioni delle sanzioni. Ma il vero interrogativo rimane: DeepSeek come ha fatto davvero a ottenere questi risultati? La risposta a questa domanda sta ridisegnando gli equilibri del settore tecnologico globale.

Alcune fonti di questo articolo:

- https://www.financialsense.com/blog/21150/why-deepseek-tanked-us-tech-stocks

- https://www.treccani.it/magazine/atlante/societa/cos-e-deepseek-la-nuova-ai-cinese-che-sfida-l-occidente.html

- https://www.businesstoday.in/technology/news/story/excellent-ai-advancement-nvidia-responds-to-rising-popularity-of-chinas-deepseek-462210-2025-01-28

- https://blog.promptlayer.com/openai-vs-deepseek-an-analysis-of-r1-and-o1-models/

- https://www.amitysolutions.com/blog/deepseek-r1-ai-giant-from-china

- https://www.prompthackers.co/compare/gpt-4o/deepseek-r1

- https://www.statista.com/chart/amp/33114/estimated-cost-of-training-selected-ai-models/