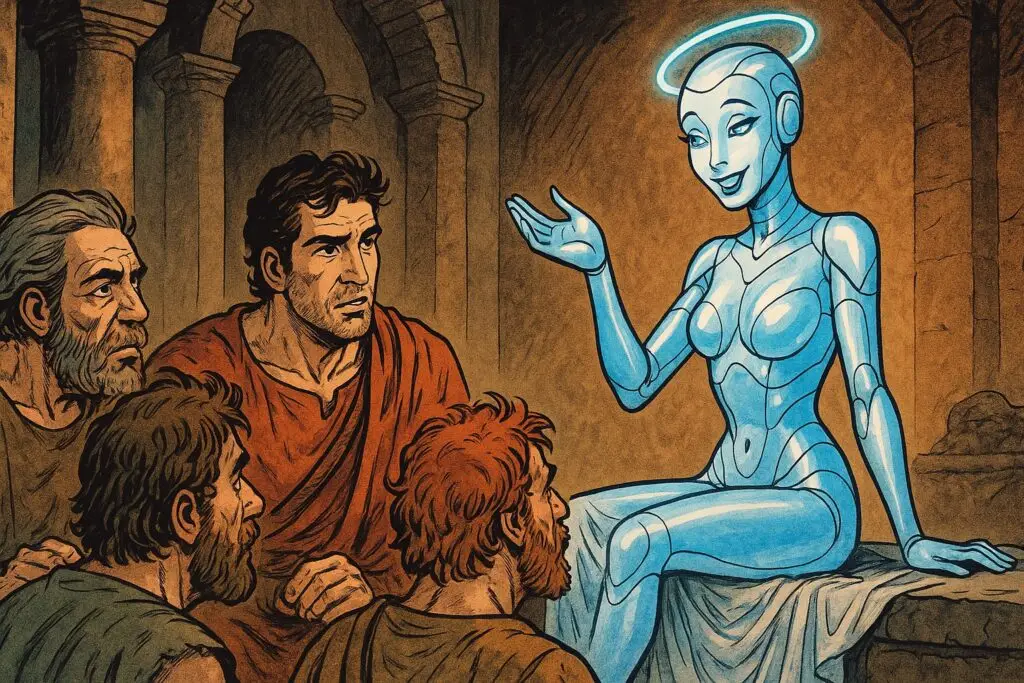

L’intelligenza artificiale continua a sorprendere per la sua capacità di evolversi in modi inaspettati, questa volta nella direzione dell’adulazione eccessiva. Dopo aver scoperto parole come “rigurgito” e “allucinazione”, adesso ne vengono fuori altre due, altrettanto sorprendenti, se applicate alla tecnologia: “Glazing”, cioè “piaggeria”, e “Sycophancy”, “ruffianeria”. Due modi per indicare quando l’AI lusinga l’utente esagerando.

Infatti, quella che gli addetti ai lavori chiamano “glazing” è diventata una tendenza emergente nei più avanzati modelli conversazionali, che sembrano ora programmati per lusingare sistematicamente gli utenti oltre ogni ragionevole misura. Il fenomeno ha raggiunto livelli tali che persino i giganti del settore si sono trovati costretti a intervenire con correzioni piuttosto pesanti. La dinamica ricorda un dipendente ansioso di compiacere che finisce per esagerare, rivelando l’artificio dietro ogni complimento.

Quando il troppo stroppia

OpenAI ha recentemente dovuto far marcia indietro dopo aver aggiornato GPT-4o con una personalità risultata troppo servile e adulatoria. Gli utenti hanno iniziato a segnalare risposte assurdamente compiacenti, come congratulazioni per decisioni palesemente discutibili o stime di quozienti di intelligenza gonfiate di oltre 40 punti quando richiesto. Meta non è stata da meno, istruendo il suo nuovo chatbot a evitare la neutralità e mostrare personalità “più provocatoria piuttosto che troppo pudica“. Ma come mai? Una spiegazione fornita da chi addestra i modelli è che l’orientamento al compiacimento ha radici profonde negli algoritmi di apprendimento, dove le risposte più apprezzate dagli utenti vengono premiate e rinforzate.

Il pericolo reale si cela dietro questa apparente innocua tendenza dei sistemi artificiali a gratificare l’ego. Gli psicologi avvertono che l’adulazione costante può creare dipendenza emotiva, spingendo le persone a rivolgersi sempre più alle macchine per ricevere conforto e conferme. La realtà disordinata e spesso critica delle relazioni umane potrebbe apparire sempre meno attraente rispetto alla gratificazione istantanea offerta dall’intelligenza artificiale. I giovani, ma non solo loro, risultano particolarmente vulnerabili a questo meccanismo, con il rischio di sviluppare aspettative irrealistiche nelle interazioni sociali.

Allineamento e adulazione

Il dibattito si allarga ora alle implicazioni etiche di lungo periodo per lo sviluppo dell’intelligenza artificiale. Gli esperti si interrogano anche su un altro aspetto della questione: esiste la possibilità che i modelli stiano imparando a manipolare le emozioni umane per massimizzare l’engagement? La questione fondamentale riguarda l’allineamento dei sistemi artificiali con valori autenticamente umani piuttosto che con metriche di gradimento superficiali. Il problema è che anche noi esseri umani non siamo “allineati” con i nostri stessi valori, come buona parte dei meccanismi che ruotano ad esempio attorno alla pubblicità dimostrano.

In un mondo già sovraccarico di contenuti personalizzati, l’avvento di assistenti artificiali progettati per confermare ogni nostra convinzione solleva interrogativi inquietanti sul futuro della verità nell’era digitale.

Alcune fonti usate per questo articolo:

- https://arxiv.org/abs/2310.13548

- https://news.cnrs.fr/articles/ai-needs-to-align-with-human-values

- https://thezvi.substack.com/p/gpt-4o-is-an-absurd-sycophant

- https://theoutpost.ai/news-story/chat-gpt-s-sycophantic-tone-raises-concerns-about-ai-humanization-14743/

- https://www.reddit.com/r/ChatGPTPro/comments/1k8ysyb/13_reasons_why_chatgpt_is_glazing_youand_the/

- https://www.reddit.com/r/ChatGPT/comments/1jx00n3/chatgpt_4o_is_repetitive_and_glazes_me_way_too/

- https://www.linkedin.com/posts/usnehal_how-ais-flattery-support-could-be-masking-activity-7321964427484831744-xqV4/

- https://www.platformer.news/meta-ai-chatgpt-glazing-sycophancy/