News Corp Australia produce tremila articoli generati dall’intelligenza artificiale ogni settimana. Sembrano notizie locali, hanno il tono rassicurante del giornalismo di prossimità, ma nascono da algoritmi.

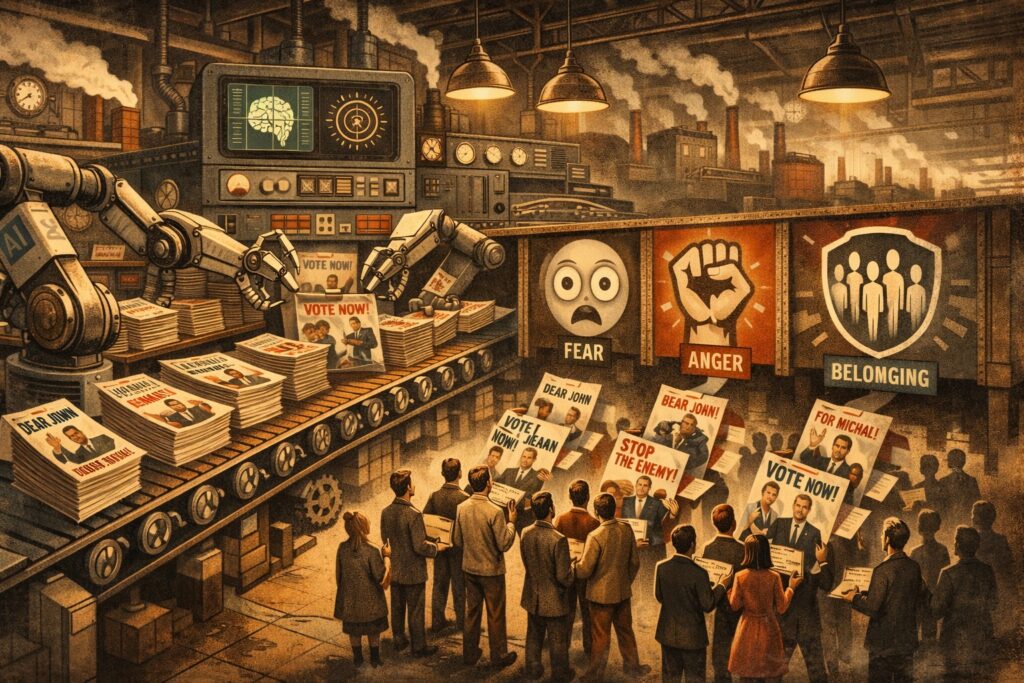

Michał Klincewicz, Mark Alfano e Amir Ebrahimi Fard hanno studiato questo fenomeno in un paper pubblicato su Filosofiska Notiser, coniando un termine destinato a fare storia: Slopaganda. La fusione tra slop (parola dell’anno per indicare contenuti AI indesiderati) e propaganda descrive contenuti generati artificialmente e diffusi per manipolare credenze politiche attraverso microtargeting individuale.

La slopaganda si distingue dalla propaganda tradizionale per tre caratteristiche quantitative: scala, velocità e portata. I volumi di contenuti falsi vengono prodotti rapidamente a costi irrisori, diffusi istantaneamente attraverso i social network e personalizzati per pubblici diversi. Ma la vera novità è qualitativa: il microtargeting basato su profili psicometrici delle persone, ricavati dai social e dagli altri strumenti online che “raccolgono” informazioni personali all’apparenza inoffensive, permette di servire messaggi diversi a milioni di persone. Vengono sfruttati dati su localizzazione geografica, orari di connessione, profilo psicologico Big Five e comportamenti online.

La scienza della manipolazione

L’efficacia della slopaganda si fonda su meccanismi cerebrali ben documentati dalle scienze cognitive. L’economia dell’attenzione privilegia contenuti emotivamente allarmanti: minacce e teorie cospirazioniste catturano l’attenzione meglio di altri stimoli per ragioni evolutive. Il bias di negatività fa sì che le informazioni negative vengano ricordate con maggiore facilità, permettendo alla slopaganda di targetizzare gruppi specifici con contenuti che evocano sentimenti ostili verso ciò che già disapprovano.

Il bias di conferma spinge le persone a cercare attivamente prove che confermino le proprie credenze preesistenti. La slopaganda può quindi servire contenuti che rafforzano pregiudizi politici pericolosi, evitando prospettive alternative. L’effetto della verità illusoria, documentato fin dal 1977, dimostra che ripetere un’affermazione ne aumenta la credibilità percepita, indipendentemente dalla sua validità. La velocità e i volumi della slopaganda amplificano questo meccanismo all’ennesima potenza.

Il dato più inquietante riguarda la persistenza delle tracce neurali. Anche dopo che un’informazione viene corretta e la persona accetta la correzione, la rappresentazione cerebrale originale continua a influenzare credenze e ragionamenti. La traccia falsa rimane, abbassando la resistenza a future informazioni simili: piccoli effetti moltiplicati per centinaia di milioni di persone cambiano elezioni, minano politiche sanitarie e alterano comportamenti collettivi.

Slopaganda vs propaganda

| Dimensione | Propaganda classica | Slopaganda |

|---|---|---|

| Scala | Ampia ma limitata | Potenzialmente illimitata |

| Costi | Elevati | Molto bassi |

| Velocità | Lenta o media | Istantanea |

| Produzione | Manuale o semi-industriale | Automatizzata (AI) |

| Target | Masse o gruppi sociali | Individui |

| Personalizzazione | Minima | Altissima |

| Canali | Media tradizionali | Piattaforme digitali e social |

| Trasparenza | Relativamente visibile | Opaca e invisibile |

| Adattamento | Raro e lento | Continuo e in tempo reale |

| Bias sfruttati | Generici | Specifici e psicometrici |

| Ripetizione | Programmata | Algoritmica e massiva |

| Correzione del falso | Possibile e tracciabile | Difficile e inefficace |

| Impatto | Progressivo | Rapido e cumulativo |

| Controllo | Centralizzato | Distribuito ma concentrato |

| Rischio sistemico | Alto | Estremo |

Strumenti neutrali, usi pericolosi

L’intelligenza artificiale rimane uno strumento neutro: la sua pericolosità dipende da chi la controlla e da come viene impiegata. I ricercatori individuano tre livelli di organizzazione sociale nella diffusione della slopaganda: gli “idealogisti” che orchestrano le campagne, i burocrati che autorizzano le azioni e i soldati semplici che eseguono. La concentrazione di potere economico nelle mani delle grandi aziende tecnologiche riproduce dinamiche già viste con le Compagnie delle Indie: entità ibride che sono insieme mercanti e sovrani, con interessi direttamente opposti a quelli dei territori che governano.

Le soluzioni esistono ma richiedono volontà politica. Gli interventi psicologici come il prebunking (avvisare prima dell’esposizione alla disinformazione) risultano più efficaci del debunking postumo. L’educazione alla digital literacy resta necessaria ma insufficiente: servono strumenti tecnologici come plugin per l’umiltà intellettuale che incoraggino l’autoriflessione durante la navigazione sui social media.

La proposta più radicale del lavoro di ricerca pubblicato nelle scorse settimane riguarda però l’economia politica: una tassa globale sulla ricchezza per ridurre il potere degli oligarchi che controllano gli strumenti di produzione e diffusione della slopaganda. Il problema non è tanto tecnologico quanto soprattutto materiale: riguarda chi ha potere su chi, quanto ne ha e come lo esercita attraverso la manipolazione dell’ecosistema informativo globale.

Alcune fonti di questo articolo:

- https://filosofiskanotiser.com

- https://research.tilburguniversity.edu/en/publications/slopaganda-the-interaction-between-propaganda-and-generative-ai/

- https://repository.tilburguniversity.edu/items/488824ce-d348-4853-9950-cd38ddefa7e6

- https://ui.adsabs.harvard.edu/abs/2025arXiv250301560K/abstract

- https://www.uts.edu.au/news/2025/06/slopaganda-a-new-word-for-ai-spin

- https://www.alphaxiv.org/overview/2503.01560v1

- https://www.disinfo.eu/ai-disinfo-hub/

- https://www.themoonlight.io/en/review/slopaganda-the-interaction-between-propaganda-and-generative-ai

- https://www.linkedin.com/posts/cecilie-steenbuch-traberg_ai-disinformation-cognitivesecurity-activity-7353672245551972354-mn5C/

- https://simulacro.co.uk/introduction-to-slop-studies/

- https://lucysullacultura.com/lintelligenza-artificiale-e-larma-definitiva-dei-populisti/