Infatti, lo studio, analisi e implementazione di sistemi di Intelligenza Artificiale non è un’attività recente. La nascita di questo settore si può datare a metà degli anni ‘50, nel contesto del Dartmouth Summer Workshop. È in quella occasione che John McCarthy decise di riunire un gruppo di fini scienziati (fra cui Minsky, Rochester e Shannon) con l’obiettivo di approfondire il concetto di “macchine pensanti”. Fu proprio John McCarthy a coniare il nome Artificial Intelligence.

Questi settanta anni di ricerca hanno portato all’invenzione di una vasta quantità di sistemi di AI che sono correntemente impiegati in moltissime applicazioni che usiamo abitualmente. Eppure nessuno di questi sistemi ha mai fatto parlare così tanto di sé quanto i Large Language Models, portando all’erronea concezione del pubblico generalista che l’AI coincida con questi LLMs.

In questo articolo illustreremo come l’AI sia un campo vastissimo e come i sistemi di intelligenza artificiale permeano la nostra “vita tecnologica” da ben prima dell’arrivo degli LLMs. Cercheremo così di rispondere ad una domanda fondamentale: cosa è cambiato con i LLMs? Perché hanno riscosso questo straordinario successo?

Cosa è l’Intelligenza Artificiale

Iniziamo con una doverosa definizione di cosa è l’Intelligenza Artificiale. L’Intelligenza Artificiale è una branca dell’informatica che studia e sviluppa sistemi in grado di svolgere compiti che tradizionalmente richiedono l’uso dell’intelletto umano.

La ricerca nel campo dell’AI ha portato alla nascita di alcuni sotto-campi che si sono specializzati nello studio di diversi aspetti dell’intelligenza umana, i quali vengono poi sfruttati per risolvere problemi specifici (che in gergo si chiamano task o applicazioni). Una lista parziale di questi macro-campi è la seguente:

- Ragionamento e problem-solving, che si occupa dello sviluppo di sistemi che cercano di riprodurre tramite macchine il processo di ragionamento passo-passo necessario per risolvere problemi formali o fare deduzioni logiche.

- Rappresentazione della conoscenza, che si occupa di elaborare conoscenza per poterla rendere fruibile dalle macchine.

- Natural language processing, che si occupa dello studio e della comprensione del testo. Task tipici sono machine translation, information extraction e question answering.

- Percezione, che si occupa dello studio e della comprensione di segnali raccolti da sensori quali telecamere e microfoni. Dal lato della computer vision abbiamo task tipici quali image classification e face recognition mentre per quanto riguarda il suono l’esempio più classico è il task di speech recognition.

Un altro campo particolarmente rilevante è quello dei sistemi di raccomandazione, i quali hanno lo scopo di suggerire ad un utente un nuovo contenuto che sia conforme al suo interesse. L’esempio più ovvio è la classica sezione Articoli Correlati di Amazon, ma anche la For You Page di TikTok. Praticamente tutti i social media (Twitter, Facebook, Instagram, ecc.) e le applicazioni multimedia (Youtube, Netflix, Spotify, ecc.) fanno uso di un qualche tipo di sistema di raccomandazione.

È importante osservare che naturalmente questi filoni non sono a tenuta stagna e vi sono diverse sinergie fra loro. Per esempio, Netflix potrebbe far uso di sistemi di natural language processing per “comprendere” le descrizione dei suoi prodotti e così guidare il proprio sistema di raccomandazione.

Dalle applicazioni alle tecnologie

Ora che abbiamo una infarinatura relativa all’Intelligenza Artificiale possiamo affrontare un tema piuttosto complesso: come funzionano questi sistemi?

Naturalmente non esiste un solo modo di risolvere un task e scopo della ricerca è proprio quello di esplorare vecchie e nuove tecniche per attaccare questi task. In questa sede non entreremo nel dettaglio, ma possiamo almeno distinguere due famiglie di tecniche fondamentali.

Sistemi Esperti

Costituiscono storicamente il primo approccio alla risoluzione di problemi di AI. L’idea è relativamente semplice: una persona esperta del task affianca lo sviluppatore del sistema “infondendo” la propria conoscenza nel sistema stesso. Un classico approccio è quello dei sistemi a regole per cui se si verifica una certa condizione allora il sistema prende una certa decisione. Un esempio banale potrebbe essere quello di un sistema che gioca a scacchi: se un pezzo si può mangiare, allora mangialo. Migliaia di regole IF-THEN messe insieme vanno a costituire un agente intelligente. Questo approccio può potenzialmente funzionare ancora oggi per problemi molto specifici e ristretti.

Machine Learning

In un sistema di ML la macchina analizza dei dati relativi al problema e da essi estrapola delle regolarità latenti che poi può sfruttare per prendere decisioni. Nel contesto del machine learning una delle tecniche più usate sono le reti neurali, ispirate al funzionamento dei neuroni umani. In quanto sistemi di machine learning, le reti neurali hanno bisogno di una fase di allenamento nella quale esaminano degli esempi del problema e poi una fase di uso in cui risolvono effettivamente il problema. Il campo delle reti neurali è spesso chiamato anche deep learning, dato che queste reti hanno tanti strati e sono quindi “profonde”. Per via della loro efficacia, le reti neurali sono ad oggi impiegate in moltissimi campi dell’AI.

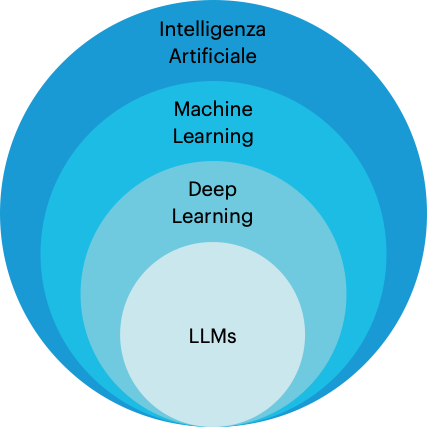

Siamo pronti finalmente a piazzare i LLMs in questo contesto. I Large Language Models sono reti neurali (ergo, sono sistemi di machine learning e di deep learning) e appartengono al campo del natural language processing.

Perciò, certo, i LLMs sono sistemi di intelligenza artificiale ma l’AI è un campo assai più vasto e che include molte altre applicazioni, nel contesto del linguaggio e non solo.

La rivoluzione dei LLMs

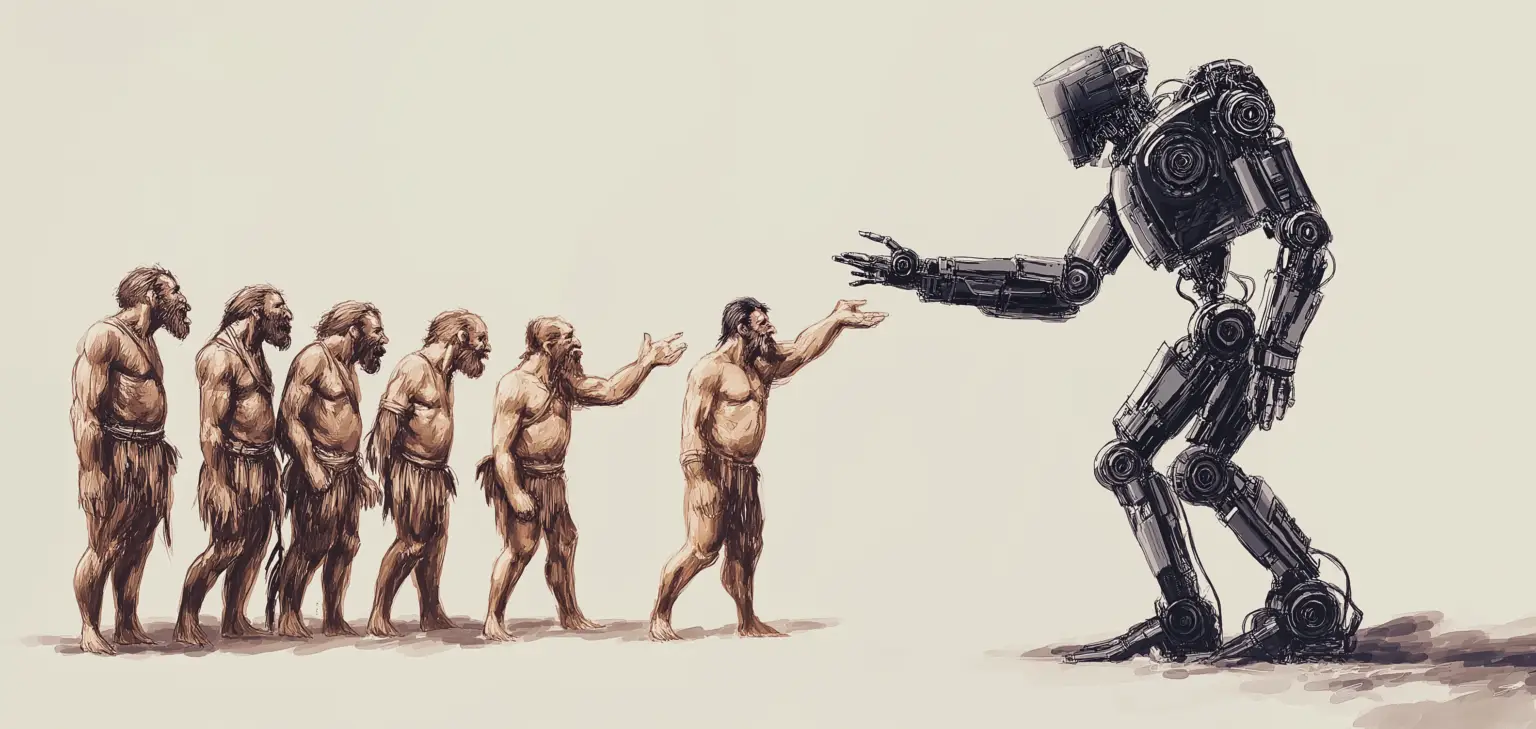

La questione è che, a differenza di molte altre tecnologie di intelligenza artificiale, i modelli LLM sembrano essere i primi facilmente comprensibili anche per chi non è esperto del settore. La applicazione naturale di questi LLMs sono i chatbot come chatGPT, i quali offrono una interfaccia linguistica usabile sostanzialmente da chiunque, mascherando la complessità del sistema che vi sta dietro. Inoltre, i LLM hanno finalmente portato alla luce un software che sembra davvero intelligente! Parla come noi, quindi deve ragionare come noi, giusto? Infine, software come chatGPT costituiscono la realizzazione del sogno tecnologico raffigurato in decine di pellicole cinematografiche.

Insomma, se pochi sono interessati ai sistemi di raccomandazione che mi propongono quale video guardare su Youtube e li subiscono passivamente, tutti vogliono cogliere l’occasione di interrogare il più intelligente oracolo tecnologico mai inventato dalla nostra specie.

Il lettore potrebbe a questo punto chiedersi: cosa c’è di male? Perché è importante sottolineare che questa innovazione di AI è la prima ad essere arrivata su tutti i titoli dei giornali per mesi?

Il problema dell’hype

Il problema è l’hype. Nel momento in cui una tecnologia molto complessa viene messa in mano a tutti e sulla bocca di tutti, le conversazioni relative a quella tecnologia non sono più orientate e guidate soltanto da chi la conosce: grandi entità commerciali vorranno sincerarsi di avere la migliore AI, gli influencers vorranno scovare l’AI che fa per te, i giornalisti vorranno parlare dell’AI e cercare di stare sulla cresta dell’onda. Nel mercato dell’attenzione, non parlare di AI è un errore imperdonabile. Conseguenza diretta è anche la rappresentazione errata di questi sistemi e delle loro reali capacità.

È soprattutto nel contesto social che questo fenomeno ingovernabile si è manifestato nei recenti anni. “AI” è diventata la nuova buzzword, ma non è un fenomeno nuovo, chiaramente. Lo abbiamo già visto succedere con la blockchain, le criptovalute e gli NFT. Sia chiaro, gli LLM non sono una bolla: la tecnologia c’è, è reale e stupefacente (sebbene non necessariamente per i motivi per cui viene promossa). D’altro canto il proliferare di AI-guru, corsi sull’AI, aziende AI-driven e dispositivi AI-based costituisce un contesto fertile per truffe ed approfittatori o quantomeno per progetti che promettono ben più di quel che possono mantenere (sì Rabbit mi riferisco a te).

Quando l’hype è alle stelle l’istinto di avventurarci e la paura di perdere una occasione unica sono naturali. Ma è proprio nella frenesia dell’hype che è invece necessario fare un passo indietro e – laddove possibile – cercare di capire che cosa sta succedendo.

Una parola conclusiva

L’hype intorno al tema dell’Intelligenza Artificiale porta aziende e organi di informazione alla divulgazione di articoli/notizie con titoli sensazionalistici e imprecisi nel migliore dei casi ed esplicitamente ingannevoli nei peggiori (ricordiamo il caso della presentazione di Gemini). Non dimentichiamo che anche i maggiori esperti in questo campo non hanno risposta a tutte le domande. Queste tecnologie sono relativamente nuove e ci vuole tempo per comprenderne le reali funzionalità e i limiti relativi.

Con questo articolo abbiamo fatto chiarezza in merito alla relazione che esiste fra LLMs e il campo dell’AI, mostrando come la percezione che “l’AI è ovunque” sia dovuta per lo più a strategie di marketing guidate dall’hype. Infatti, svariati sistemi di AI sono presenti nelle applicazioni tecnologiche di uso comune da parecchio tempo.

Se siete interessati ad approfondire il tema dei LLMs il suggerimento è quello di affidarsi a fonti autorevoli e competenti, sfuggendo al magnetismo dei titoli catastrofici e altisonanti. Uno studio cauto e meno hype-driven è l’ingrediente fondamentale per la costruzione di un senso critico sano e necessario per navigare la tematica dell’Intelligenza Artificiale, in questi anni e nel futuro che ci si prospetta.