Mettere sott’acqua un intero datacenter ha senso? In realtà sì, non è per niente una cattiva idea. E la sorpresa è che lo stiamo già facendo. Ad avere l’idea e soprattutto a portarla avanti concretamente per prima è stata Microsoft, con il suo Project Naticik, che risale addirittura al 2014. Intanto però, per capire cosa sta succedendo e soprattutto cosa potrebbe succedere, facciamo un passo indietro.

I datanceter e la corsa al cloud

Di centri di calcolo, o datacenter in inglese, il mondo non ne ha mai abbastanza. Con l’esplosione prima del cloud e poi del bisogno di avere posti dove addestrare i modelli di intelligenza artificiale, la costruzione di spazi nei quali ospitare migliaia e migliaia di server è diventata sempre più diffusa.

I centri di calcolo però hanno dei requisiti particolari. Intanto, devono essere posizionati strategicamente, poi devono essere in zone “sicure”, sia dal punto di vista climatico che geologico (soprattutto per i terremoti) e geopolitico (lontano dalle guerre, se possibile). Ancora, devono poter essere collegati bene ai grandi cavi sottomarini o comunque alle centrali di interscambio tra differenti sotto-reti di internet, i famosi Internet Exchange (dei quali abbiamo già parlato).

Infine, con la gara a fornire sempre più servizi a terzi, i big del settore si sono impegnati in una gara a chi aumentava al massimo la sua capacità di calcolo. Il vincitore, a quanto pare, è Amazon con la sua divisione AWS (Amazon Web Services), quella che ha praticamente inventato il cloud.

In terza posizione c’è Google, che del cloud ha fatto fin dagli esordi la sua bandiera: tutti i suoi servizi sono da sempre (cioè dall’inizio degli anni Duemila) nella nuvola.

A sorpresa però, perché molti pensano a Microsoft solo come la creatrice di Windows, Teams e Office (la suite che comprende Word, Excel, PowerPoint), la seconda posizione è sua. Con il servizio cloud che si chiama Azure. Proprio questo servizio, fortemente voluto dall’amministratore Satya Nadella, è strategico anche nel settore dell’intelligenza artificiale.

Mettere i server vicino ai clienti

Una caratteristica dei datacenter, come abbiamo visto, è che devono essere il più vicino possibile ai grandi snodi. E, se possibile, anche ai posti dove si trovano gli utilizzatori: è il paradigma dell’Edge computing.

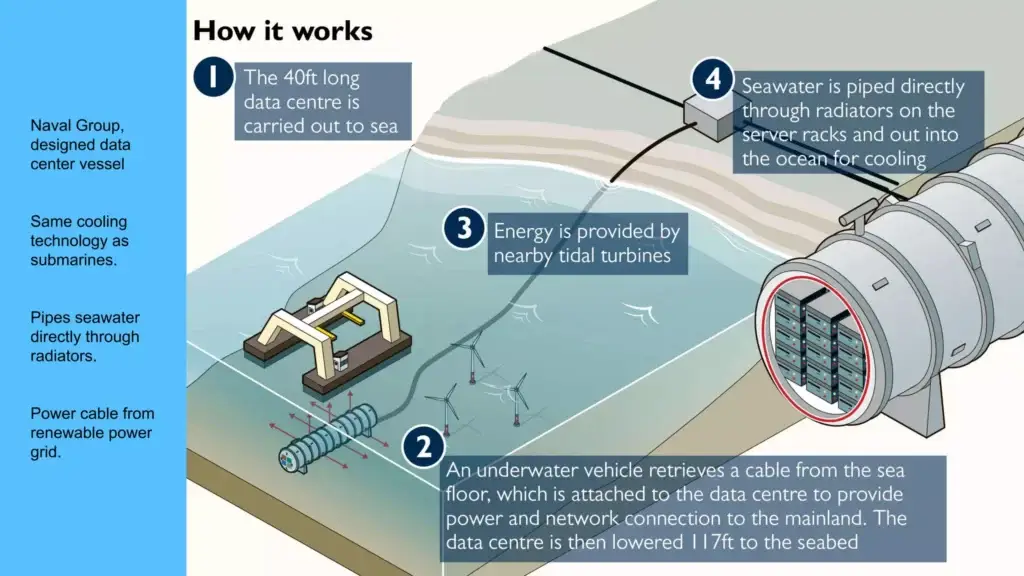

Per questo nel tempo sono state provate varie soluzioni: datacenter da campo, datacenter mobili, addirittura inseriti in container per poter essere spostati velocemente a seconda della bisogna. Sino a che a quelli di Microsoft è venuto in mente di metterli sott’acqua.

Il Project Nantuk è stata una versa sfida, perché ha richiesto la capacità di creare un gigantesco contenitore perfettamente stagno in grado di avere al suo interno centinaia di “blade” contenuti nei rack, gli armadi caratteristici dei centri di calcolo.

Ma il progetto ha avuto successo perché in realtà ha più vantaggi che non problemi: innanzitutto fa risparmiare quasi metà dell’energia necessaria al funzionamento dei server. Questo perché in un datacenter tipicamente quasi metà dell’energia serve per dissipare il calore generato soprattutto dai processori. Questo perché le CPU e le GPU sono manufatti straordinariamente poco efficienti da un punto di vista termodinamico, che disperdono buona parte dell’energia usata per alimentarli sotto forma di calore.

Poi, un datacenter sottomarino consente una vita più lunga ai server, perché non serve tenerli in una miscela ricca di ossigeno, visto che non ci sono operatori che hanno accesso quotidiano. Invece, con un’atmosfera a base di azoto i macchinari sono più stabili, meno soggetti a ossidazioni e altre forme di usura. Inoltre, la mancanza di accesso di personale esterno rende l’atmosfera più pura e quindi diminuisce gli accumuli di polvere e altre impurità.

Uno dei vantaggi di posizionare un datacenter sott’acqua è la colocazione delle fonti di alimentazione: con un impianto eolico offshore il centro di calcolo diventa completamente autonomo

I datacenter sottomarini poi sono strategici anche perché prendono molto meno spazio, possono essere posizionati lungo quelle cose sulle quali arrivano anche i cavi sottomarini per le telecomunicazioni. E infine, sono nativamente dei sistemi edge perché circa metà della popolazione mondiale vive entro 120 miglia dalle coste. Infine, sott’acqua sono anche più al sicuro sia da danni fisici che da possibili sabotaggi e compromissioni, perché decisamente meno accessibili che sulla superficie.

Metterli sott’acqua apre anche ad altri piccoli vantaggi, come la sinergia con le forme di alimentazione green: posizionare il centro di calcolo lungo la costa permette di alimetarlo grazie alla colocazione di un impianto eolico offshore. Bastano anche venti leggeri per farlo funzionare al 100 per cento. E una eventuale linea elettrica di backup può essere accoppiata al cablaggio in fibra ottica necessario per il trasporto dati.

L’interesse della Cina

Nonostante il primo progetto operativo sia stato messo in piedi da Microsoft, che sta continuando a espandere la sua rete di datacenter sottomarini a partire dal primo immerso nelle acque della Nuova Caledonia, la maggior interessato a portare avanti questa strategia sembra essere la Cina.

Pechino ha fane di centri di calcolo sia per recuperare il gap con gli Stati Uniti che per riuscire a soddisfare il bisogno di servizi digitali dei suoi oltre 1,4 miliardi di cittadini. Solo per i servizi di anagrafe digitale ci vuole una capacità di calcolo distribuita enorme, che deve essere oltretutto indirizzata in zone tra loro lontanissime. E poi ci sono le aziende, alcune centinaia di milioni tra grandi e piccole, che vogliono anche loro sfruttare le risorse cloud,

Per questo sono già attivi vari progetti per la realizzazione di centri di calcolo sottomarini che seguono più o meno le specifiche di quelli pensati da Microsoft e sperimentati anche da altri aziende. Con la differenza che la Cina pensa in grande e realizza su scala enorme: solo l’Hainan Undersea Data Centre, pensato per avere le prestazioni di 5 milioni di PC di fascia alta, pesa 1.300 tonnellate e viene immerso sotto 35 metri d’acaqua. Quando la struttura sarà completa, con 100 moduli come il primo di questo tipo, permetterà di risparmiare 122 milioni di Kilowattora di elettricità e una superficie di quasi dieci campi da calcio. Dovrebbe essere pronto per la fine del 2025, al costo di 879 milioni di dollari.

Se funziona come previsto non c’è da dubitare che sarà solo il primo dei mega centri di calcolo sottomarini.

Alcune delle fonti di questo articolo:

- https://news.microsoft.com/source/features/sustainability/project-natick-underwater-datacenter/

- https://www.microsoft.com/insidetrack/blog/how-microsoft-kept-its-underwater-datacenter-connected-while-retrieving-it-from-the-ocean/

- https://www.slideshare.net/slideshow/underwater-aradhana-recorded/230692665

- https://www.datacenterdynamics.com/en/analysis/building-underwater/